APRIL实验室5篇论文被ECCV 2022录用

ECCV 2022放榜了!据统计,今年ECCV共有5803篇论文投稿,接收率28%!ECCV全称European Conference on Computer Vision,即欧洲计算机视觉国际会议,每两年召开一次,与国际计算机视觉与模式识别会议(CVPR)和国际计算机视觉大会(ICCV)并称计算机视觉方向的三大顶级会议。

恭喜APRIL实验室博士生黄田鑫、赵祥瑞、徐超、硕士生李梓彰的论文被ECCV 2022录用!!!

01 Resolution-free Point Cloud Sampling Network with Data Distillation(基于数据蒸馏的分辨率适应性点云采样网络) – 黄田鑫

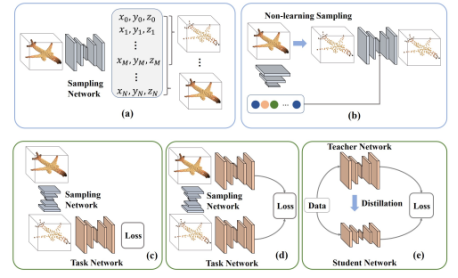

任务导向的点云采样旨在针对特定的任务(点云重构,识别,匹配等)对点云采样网络进行优化,使得降采样得到的点云更加符合对应任务的需求。现有的基于深度学习的点云采样网络往往具有以下两个问题:(1)采用全连接网络生成粗采样点,对分辨率的灵活性很差,需要采用下图(a)所示的架构生成与输入点云分辨率相同的点云,并从中按顺序获取所需分辨率的采样点,不仅会生成许多无用的点,而且同时训练多个分辨率消耗较大;(2)如图(c)所示,预训练任务网络中包含的信息没有被充分利用,在现有的架构中仅仅起到了传递梯度的作用。

针对(1)中的问题,我们提出了一种简单有效的采样网络架构,通过直接用网络驱动使用非学习的方法获取的种子点进行采样,在这种架构下只需要改变种子点的分辨率就可以获取不同分辨率的采样点,而无需网络结构的变动,而且不会生成额外的无用采样点;针对(2)中的问题,我们引入了数据蒸馏的概念,如上图(d)所示,我们使用采样前后的点云在相同任务网络上的性能为采样过程增加额外的约束以进一步引入预训练任务网络中所包含的信息。注意我们的方法与知识蒸馏的不同之处在于,知识蒸馏采用相同的数据约束不同的网络,而数据蒸馏采用相同的预训练网络约束不同的数据。

网络的具体架构如上图所示,完整点云与非学习采样策略获取的种子点分别进行特征提取后进行特征融合,并据此为种子点预测偏移量进行驱动,投影回原始点云后得到最终的采样点,网络的训练采用真值标签和数据蒸馏共同进行约束。实验表明,PCDNet相比于现有方法,在较高的采样效率,更低的内存消耗以及最小的参数量下,其采样点在重构和分类任务上都有显著的提升。

02 Learning to Train a Point Cloud Reconstruction Network Without Matching(无需匹配的可学习点云重构约束网络)- 黄田鑫

点云重构是一个非常基本的任务,其主要的目标是使用网络构建与输入模型尽可能保持一致的点云模型,相关的应用包括点云无监督学习(利用重构点云的中间特征进行识别),以及点云补全(根据残缺不全的模型重构出形状完整的点云模型)等等。为了训练这些点云重构网络,需要有一种合理的方式度量生成与输入点云之间的距离。现有的方法基本都是借助不同的匹配算法进行两个点云之间逐点的匹配,并以平均的匹配距离作为点云模型之间的距离。然而,由于匹配算法实际上是对形状误差的一种近似,这样的约束方式会为结果引入不可避免的偏差。

因此,针对这一问题,本文提出了一种可学习的方法PCLossNet来替代直接的点到点匹配过程计算,从点云模型中提取对比矩阵,采用对比矩阵之间的距离训练点云重构网络,同时采用对抗的方法进行参数更新促使其不断搜索误差较大的区域进行约束。PCLossNet采用Aggregation Controller(AC)模块融合来自于生成点云和输入点云的特征,并据此预测聚合中心点以及聚合范围。而Graph Aggregation(GA) Processor则根据聚合中心点以及聚合范围所确定的分布从输入与生成点云中分别提取对比矩阵。由于对比矩阵完全依据网络进行聚合得到,避免了引入传统匹配算法进行训练所带来的固有误差,且基于对抗的优化策略可以很大程度上避免陷入局部最优解。

按照中心点和聚合范围生成网络结构的不同,PCLossNet可以分为LNSA(基于采样头的AC模块)和LNFC(基于全连接头的AC模块)。

实验表明,PCLossNet能够更好地挖掘重构网络的潜力,实现更加准确的重构结果,同时其训练效率相比于EMD也有显著的提升,且通过微调生成步和对抗步的比例,可以在效果略微下降的情况下进一步提升效率。

03 SuperLine3D: Self-supervised Line Segmentation and Description for LiDAR Point Cloud(自监督激光点云线特征分割描述)- 赵祥瑞

背景介绍:

点云配准是激光SLAM中的一个重要环节,传统配准方法如NDT、ICP等,需要一个好的初值,在大旋转角的情况下极易失效。受激光雷达扫描原理的制约,激光点云在近处点云密集、远处稀疏,同一个点在多次测量中不一定能都被观测到。现有的基于learning-based点云特征提取方法均为点特征,可以达到较好的配准精度。但存在的问题是误匹配较多,如D3Feat,在250对匹配点下内点率仅为45%,客观上限制了点云特征的应用。在图像特征领域,线特征也是一大类别,在视觉SLAM中已有了非常多的应用。在激光点云中,电线杆和建筑物边缘是城市道路上经常可以观测到的特征,在点云配准任务中也可发挥关键作用。我们提出了首个基于自监督学习的激光点云线段分割和描述子提取方法,线段分割明显优于现有方法,基于线特征匹配的点云配准与现有的点特征配准方法精度相当。

方法:

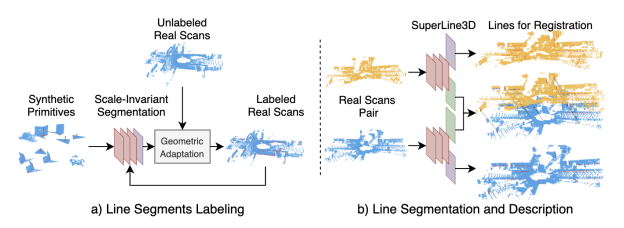

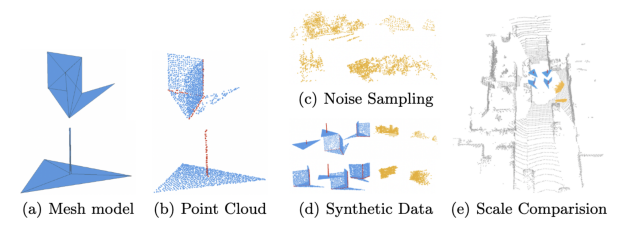

点云数据量大,对于线段这种细粒度特征进行手动标注不现实,因而我们参考图像点特征SuperPoint设计了一个点云线特征自动标注流程,将简单合成点云上训练得到的分割模型迁移到真实激光点云上。图2展示了数据生成过程。要标注的线特征包含面面交线和杆状物两种,图2(a)为包含两种线特征的网格模型,经均匀采样得到图2(b)中的点云。由网格模型采样得到的点云较为简单,真实点云分布非常复杂,因此我们从真实点云中截取了部分噪声点云,如图2(c)所示。将噪声点云加入到线特征标注点云中,得到一帧训练数据,如图2(d)所示。图2(d)展示了在相同尺度下,合成点云与真实激光点云的可视化对比,二者尺度差异巨大,现有方法在合成点云上训练的模型无法在真实点云上得到合理的预测结果,因此我们设计了一种尺度不变的特征编码方法,如公式1所示,对每个点搜索k个最近邻点,将其 L1距离的和除以L2距离的和,即可将Sim(3)变换中的尺度因子消除,从而实现尺度不变。

图3展示了线特征自动标注流程。我们首先在合成点云上训练尺度不变的线特征分割模型,对真实点云施加多次随机的平面旋转变换,变换后的点云分别用分割模型预测,统计每个点被预测为直线点的次数,超过80%的点用作候选点进行区域生长。由于点云数据是离散的,这里通过k-近邻搜索定义其连通性,以候选点中的每个点作为种子点,迭代进行k近邻搜索和直线拟合,当拟合直线点数量保持不变时,一条直线即被提取完成。

SuperLine3D网络结构如图4所示,采用3层EdgeConv模块提取特征,分别输入两个Head进行线特征分割和描述子计算。

实验结果:

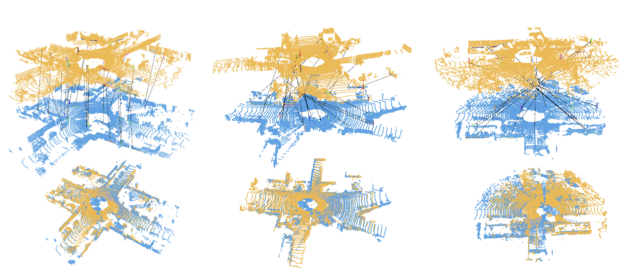

图5展示了点云线段提取算法的对比,左图为唯一一个开源的开源算法,右图为我们的方法。我们的算法误检极少,而开源算法只能提取平面上的线,无法检测杆状物,且存在大量误检,会将地面上激光扫描线检测出来。

图6展示了在KITTI数据集上的配准召回率,基于SuperLine3D的配准方法与点特征SOTA方法D3Feat和SpinNet性能相当。这里点特征配准时的最大RANSAC迭代次数为10万次。当RANSAC迭代次数减少时,如图7所示,配准性能将显著下降,其主要原因是点特征匹配的内点率较低,如D3Feat,在250对匹配点下内点率仅为45%。我们的方法平均每组点云能提取18对匹配线,在KITTI测试序列08-10上,平均内点率达到86.2%。图7中的靠近纵坐标轴的五角星代表使用所有匹配线配准的结果,在有误匹配存在的情况下,基于线特征的点云配准依然有良好的配准精度和成功率。在此基础上,我们进行了一次误匹配剔除,将配准后线线距离依然较大的匹配对当作误匹配剔除,重新进行一次配准。图7中横坐标为10^0的五角星代表误匹配剔除后的配准结果,对相对平移精度有了较大提升。

04 Designing One Unified framework for High-Fidelity Face Reenactment and Swapping(一个高保真度的统一的人脸驱动和人脸融合框架)- 徐超

背景介绍:

人脸驱动和人脸融合是两个高度相关的任务,即将两张人脸对应的属性和身份信息进行重组并且进行处理,我们想要用一个统一的端到端的框架来同时处理两个任务。

目前的一些统一方法都会借助于人脸结构先验来解耦得到属性和身份特征,再根据特定任务对这些特征进行重组来生成编辑后的人脸。这些方法存在两个问题:1.人脸结构信息(关键点和3DMM)需要额外的数据标注和复杂的预处理2.目前的方法直接对相应特征进行重组,忽略了两个任务之间的内部联系导致性能欠佳。针对以上两个挑战,我们在一个统一的框架中设计了相应的结构来端到端的实现这两个任务。我们的贡献点主要有以下几点:

1.我们使用自监督的方式来解耦得到以向量为表征的属性信息和以特征图为表征的身份信息,在推理阶段不依赖于任何的人脸先验,在极端环境下有更鲁棒的表现;

2.我们设计了一个属性迁移模块和身份迁移模块来充分利用解耦好的特征得到高保真度的人脸。我们充分挖掘了两个任务之间的内部联系,将两个迁移模块结合在一个统一的框架中来提升各自的性能;

3.我们在多个数据集中进行了充分的实验,验证了我们方法的合理性和先进性。

网络结构:

1.特征解耦模块:我们设计了一个编码器结构将源人脸和目标人脸映射成低分辨率的富含丰富的身份相关的语义特征图。类似的,我们设计了一个自编码器结构将目标人脸映射成一个特征向量,同时将这个向量解码成一个特征位移场来显式的引导属性的变化。

2.属性迁移模块:我们采用了特征重采样的方式,利用目标人脸生成的特征位移场来改变源人脸的属性信息。

3.身份迁移模块:启发于自注意力机制在各个视觉任务中的广泛应用,我们设计了一个身份迁移模块来建模两张人脸身份相关特征的交互,并且自适应的将源人脸的身份特征融合到目标人脸中。

4.生成器:我们引入了高性能人脸生成网络StyleMapGAN来提高生成人脸的真实度。

实验:

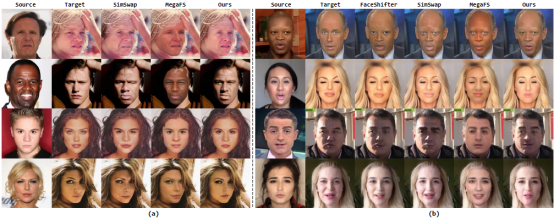

1.针对人脸驱动性能,我们在VoxCeleb2数据集上和目前先进的方法进行了充分的比较。针对人脸融合性能,我们在CelebA-HQ和FaceForensics++数据集上和目前的方法进行了充分的比较,定性和定量实验结果如下,我们的方法能够生成属性相似、身份保持的驱动人脸以及身份一致、属性保持的融合人脸,并且我们的结果有更好的保真度。

2.我们对属性迁移模块和身份迁移模块进行了充分的验证,每一个模块除了能够胜任各自的任务,属性迁移模块还能够帮助人脸融合结果保持更好的属性信息,身份迁移模块能够帮助人脸驱动结果保持更好的身份信息。

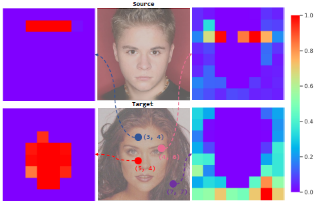

3.我们对属性迁移模块和身份迁移模块的可解释性进行了可视化实验。属性迁移模块中的特征位移图准确描述了目标图的属性信息,并且该位移图成功的引导了特征重采样来驱动源人脸。从身份迁移模块中注意力机制可视化图可以发现目标人脸中的区域能够准确地匹配到源人脸中具有相似语义的区域。

05 E-NeRV: Expedite Neural Video Representation with Disentangled Spatial-Temporal Context(利用解耦的空间-时间特征提升视频神经隐式表征能力)- 李梓彰

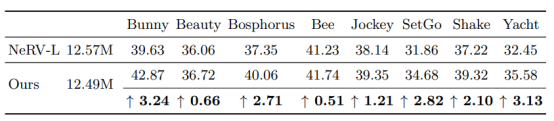

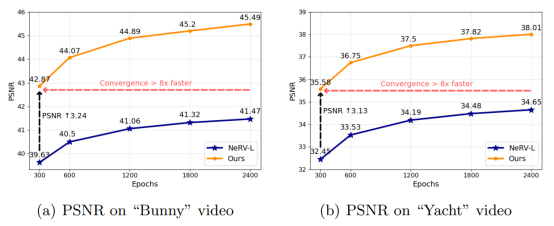

实验结论: