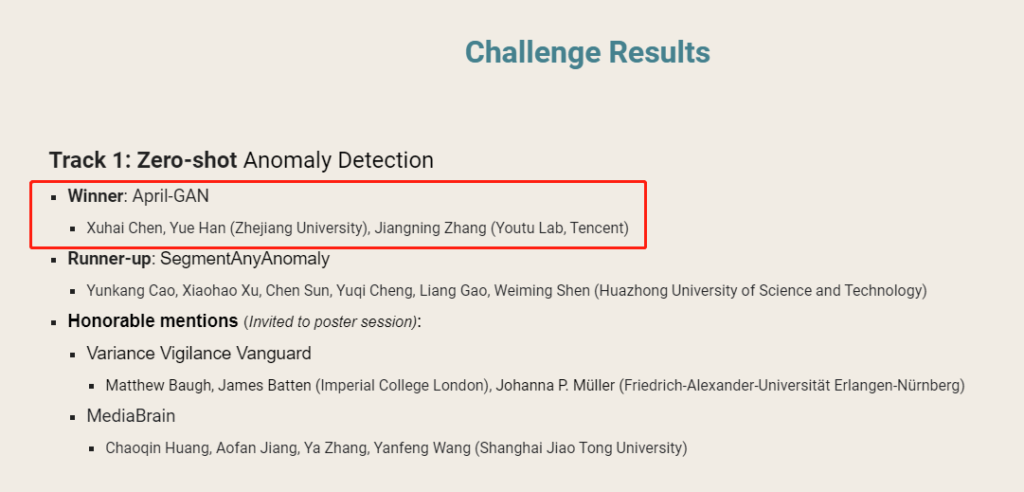

APRIL实验室联合腾讯优图实验室斩获CVPR 2023视觉异常检测(VAND)挑战赛冠军

近日,APRIL实验室联合腾讯优图实验室在CVPR 2023(IEEE国际计算机视觉与模式识别会议)中斩获了视觉异常检测(Visual Anomaly and Novelty Detection,VAND)挑战赛的冠军,本次比赛吸引了来自全球多家高校研究机构、知名企业的参与,这一荣誉标志着APRIL实验室在工业人工智能领域的技术实力和创新能力得到了权威机构的认可。

1 引言

无监督图像异常检测是计算机视觉领域中一项热门的重要研究课题,其任务目标是仅使用正常图像(即不使用真实异常图像)进行模型训练,测试时能够在图像级和像素级两个层面对正常/异常图像进行区分,在工业外观质检、工业产品零件是否安装到位、智能安全监控等领域有极大的研究意义及应用价值。实际工业质检场景中,产品类型众多、缺陷种类千变万化且收集成本较大,因此探究无监督异常检测技术在该领域的应用显得尤为重要。

2 赛题介绍

无监督图像异常检测(Unsupervised Visual Anomaly Detection)任务根据可获取的正常图像数目可分为:Multi-shot AD、Few-shot AD和Zero-shot AD,其难度随着可获取图像数目的减少而增加。对于工业视觉异常检测,当前大多数方法都侧重于multi-shot设置,即以给定的大量正常图像作为训练数据为每个类别训练特定模型。然而,现实场景中的工业产品有数百万种,为每个对象收集大量训练集并针对不同类别部署不同模型实行起来不仅周期较长且成本较高。因此,不使用(zero-shot)或使用少量(few-shot)正常图像构建冷启动模型在应用时则显得尤为必要。构建一个可以在没有或只有少数正常参考图像的情况下快速适应众多类别(multi-class)的单一模型(single model)是一种理想的解决方案,也是对社区中AD研究的公开挑战。因此AWS AI Labs联合众多高校、研究机构和MVTec数据集作者组织了两个相关方向的挑战赛道:

Track 1:Zero-shot Anomaly Detection (Anomaly Classification + Segmentation)

Track 2:Few-Shot Anomaly Detection (Anomaly Classification + Segmentation)

3 方案解析

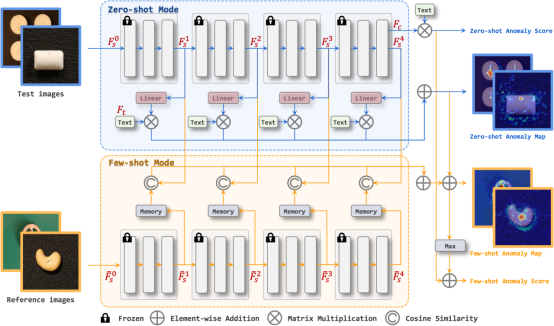

APRIL实验室联合腾讯优图实验室针对Zero-shot异常检测赛道进行了研究,基于预训练的CLIP[1]视觉语言提出了一套有效的零样本异常分类(Zero-shot Anomaly Classification)和零样本异常分割(Zero-shot Anomaly Segmentation)解决方案。具体地,我们以柱状ViT[2]作为Backbone,但提出的方案可以轻松地扩展到金字塔状结构。

(一)异常分类

基于WinCLIP[3]异常分类框架,我们提出了一种文本提示集成策略,在不使用复杂的多尺度窗口策略的基础上显著提升了Baseline的异常分类精度。具体地,该集成策略包含template-level和state-level两部分:

1)对于前者,我们从CLIP Surgery[4]中选定的85个模板提示中删掉了一些不适合AD任务的模板,如“a photo of the weird [obj.]“,最终筛选35个模板提示。

2)对于后者,我们采用通用文本来描述正常/异常对象,如“flawless,damaged“等,而没有提供过于详细的描述以保证方法的普适性,如”chip around edge and corner“。最终使用7个正常提示和5个异常提示。

模板和状态提示与样本类别名称结合后,使用CLIP文本编码器提取文本特征,并对正常和异常特征分别求平均值。最终,将正常与异常特征各自的平均值与图像特征进行对比,经过softmax后得到异常类别概率作为分类得分,见下图中蓝色Zero-shot Anomaly Score流程。

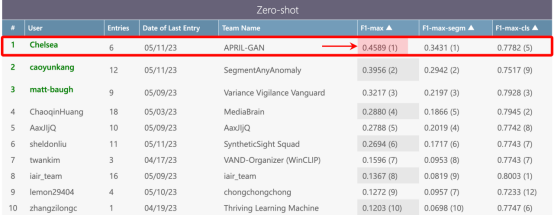

(二)异常分割

类比图像级别的异常分类方法到异常分割,一个自然而然的想法是将Backbone提取到的不同层级特征与文本特征进行相似度度量。然而,CLIP模型是基于分类的方案进行设计的,即除了用于分类的抽象图像特征外,没有将其它图像特征映射到统一的图像/文本空间。因此我们提出了一个简单但有效的方案来解决这个问题:使用额外的线性层将不同层级的图像特征映射到图像/文本联合嵌入空间中,见上图中蓝色Zero-shot Anomaly Map流程。具体地,不同层级的特征分别经由一个线性层进行联合嵌入特征空间变换,将得到的变换后的特征与文本特征进行对比,得到不同层级的异常图。最后,将不同层级的异常图简单加和求得最终结果,具体实现可参考技术报告和源代码。官方的测试数据集上提出的方法在综合F1-max指标上达到0.4589,相较于其他众多参赛队伍具有明显的优势,获得了该赛道冠军,证明了所提方法的优越性和泛化性。

(三)Few-shot扩展

得益于简单有效的结构设计,我们结合基于memory的PatchCore[5]思路将方法扩展到Few-shot赛道,在不进行任何调参的基础上获得了积极竞争的结果,获得了该赛道荣誉提名奖,我们会在后续工作中进一步探究该方法在Few-shot上的应用潜力与价值。

4 结语

技术报告及技术海报已被CVPR 2023 VAND研讨会收录,将于June 18th 11:50 AM – 12:00 PM进行相关Talk和QA。详见:https://sites.google.com/view/vand-cvpr23/schedule

相关技术方案及代码已整理并公开,详见:

> **技术报告名称**:A Zero-/Few-Shot Anomaly Classification and Segmentation Method for CVPR 2023 VAND Workshop Challenge Tracks 1&2: 1st Place on Zero-shot AD and 4th Place on Few-shot AD

> **技术报告链接**:

https://arxiv.org/abs/2305.17382

> **代码**:

https://github.com/ByChelsea/VAND-APRIL-GAN

CVPR会议

CVPR是由IEEE主办的一年一度的全球学术型顶级会议,全称“IEEE国际计算机视觉与模式识别会议”(IEEE Conference on Computer Vision and Pattern Recognition),今年将于6月18日到22日在温哥华会议中心举办。

APRIL实验室

APRIL机器人智能感知与学习实验室目前已建立一支由博士后、博士、硕士组成的研究团队。近年来在IEEE Transactions、ICRA、CVPR、IJCAI、ICCV、IROS、ICLR、AAAI/IAAI等知名期刊和顶级会议中发表论文百余篇,同时完成了国家自然科学基金,省部级课题若干项,积累了丰富的研究经验。

参考文献

[1] Radford, Alec, et al. “Learning transferable visual models from natural language supervision.” International conference on machine learning. PMLR, 2021.

[2] Dosovitskiy, Alexey, et al. “An image is worth 16×16 words: Transformers for image recognition at scale.” arXiv preprint arXiv:2010.11929 (2020).

[3] Jeong, Jongheon, et al. “Winclip: Zero-/few-shot anomaly classification and segmentation.” Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2023.

[4] Li, Yi, et al. “Clip surgery for better explainability with enhancement in open-vocabulary tasks.” arXiv preprint arXiv:2304.05653 (2023).

[5] Roth, Karsten, et al. “Towards total recall in industrial anomaly detection.” Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2022.